2025-07-16

La burbuja de la Inteligencia Artificial: Expectativas y realidades

Estudio revela que las herramientas de Inteligencia Artificial para el desarrollo de software no siempre lo aceleran

El instituto METR (Model Evaluation & Threat Research) publicó

un estudio llevado a cabo para medir el impacto de las herramientas de IA en el

desarrollo de software

Early_2025_AI_Experienced_OS_Devs_Study.pdf

Realizaron un ensayo controlado con 16 desarrolladores,

todos con experiencia moderada en proyectos de Open Source, los cuales debían

terminar 246 tareas las cuales podrían terminar en promedio en 2 horas.

Antes de iniciar, los desarrolladores pronosticaban una reducción del 24% en tiempo para completar las tareas gracias a la IA, Luego de terminar las pruebas estos mismos estimaron haber logrado una reducción del 20%, sin embargo, sorprendentemente, el resultado observado fue que el uso de herramientas de IA para desarrollar aumentó los tiempos en un 19%.

Si bien en el ensayo declaran no poder medir el impacto de los Artefactos usados, la aleatoriedad y notoriedad de la diferencia entre el desarrollo con o sin IA descartan que los resultados se deban al diseño del experimento.

A la ausencia de este tipo de estudios por parte de los fabricantes muestra que, sin demeritar las ventajas que aporta la IA, el afán de comercializar los avances nos está llevando a valorar como producto terminado a soluciones que, en la mayoría de los casos y con la rigurosidad debida, deberían considerarse como pruebas de concepto.

Solo es ver reseñas como esta de IBM: "En general, la IA está aumentando la velocidad y precisión del desarrollo y fomentando un entorno de software más confiable y seguro. El futuro traerá aún más avances. A medida que la IA generativa evoluciona, podría remodelar fundamentalmente cada etapa del desarrollo e incluso podría hacer obsoletas las metodologías ágiles, tal como las conocemos hoy."

La IA en el desarrollo de software | IBM

Puedes leer de arriba a abajo como en el artículo les atribuyen ventajas a las herramientas de IA sin el más mínimo respaldo en pruebas estadísticas, ensayos controlados o estudios científicos.

La investigación no es la única que da argumento para quienes somos escépticos respecto a los beneficios prometidos por las herramientas de IA para el de desarrollo de código. Otros estudios (Code-generating AI can introduce security vulnerabilities, study finds | TechCrunch) han demostrado estas herramientas en la actualidad pueden introducir errores e incluso vulnerabilidades de seguridad.

En la carrera por encabezar el mercado es deber de quienes tomamos las decisiones, adoptar una posición crítica para evitar caer en el Hype de la IA, y terminar confiando en productos cuyas bondades carecen de un sustento sólido y terminemos adoptando productos que terminen afectando nuestro ecosistema o volviendo humo los presupuestos

2024-11-15

Mejorando la Seguridad en Edificios Habitacionales con Tecnología Avanzada (De la mano de RedTelci)

Retos Comunes en Seguridad

Acceso no autorizado: Los edificios habitacionales pueden ser vulnerables a intrusos que buscan entrar sin permiso.

Robos: Tanto en áreas comunes como en unidades individuales, el robo es una preocupación constante.

Emergencias: En caso de incendios u otros desastres, la capacidad de reaccionar rápidamente es crucial.

Supervisión constante: La necesidad de vigilancia 24/7 puede ser un desafío logístico y financiero.

Tecnologías para Mejorar la Seguridad

Control de Acceso RFID:

Descripción: La tecnología de identificación por radiofrecuencia (RFID) permite un control de acceso eficiente y seguro mediante tarjetas o llaveros que contienen un chip RFID.

Ventajas:

Seguridad Mejorada: Solo las personas con tarjetas autorizadas pueden acceder a las áreas protegidas.

Registro de Entradas: Se mantiene un registro de quién entra y sale, lo que ayuda en el monitoreo.

Conveniencia: Es fácil de usar para los residentes y difícil de duplicar para los intrusos.

Sistemas de Alarma Avanzados:

Descripción: Los sistemas de alarma modernos pueden detectar una variedad de situaciones, desde intrusiones hasta incendios.

Ventajas:

Respuesta Rápida: Alertan a los servicios de emergencia y a los residentes inmediatamente.

Monitoreo Remoto: Muchos sistemas permiten el monitoreo a través de dispositivos móviles.

Integración con Otros Sistemas: Se pueden integrar con cámaras de seguridad y otros dispositivos de domótica para una protección integral.

Implementación Efectiva

Evaluación de Necesidades: Cada edificio es único, por lo que es importante realizar una evaluación de seguridad para identificar las necesidades específicas.

Instalación Profesional: Contratar a profesionales para la instalación asegura que los sistemas funcionen correctamente y se configuren adecuadamente.

Educación de los Residentes: Informar a los residentes sobre cómo funcionan los sistemas y la importancia de su uso correcto.

Mantenimiento Regular: Programar mantenimientos periódicos para asegurar que los sistemas de seguridad estén siempre operativos.

Conclusión

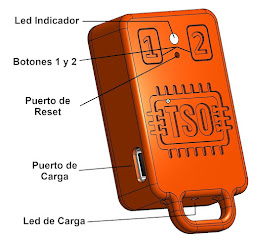

panorama de la seguridad en edificios habitacionales. No solo proporcionan una capa adicional de protección, sino que también ofrecen comodidad y tranquilidad a los residentes. Al adoptar estas soluciones tecnológicas, es posible hacer frente a los retos de seguridad actuales y crear entornos residenciales más seguros y confortables.

Como recomendación en Medellín se cuenta con RedTelci como aliado para la seguridad de su edificio y cuenta con soluciones especialmente diseñadas para aquellos que no cuentan con portero o que quieren reducir los costos y aun así mejorar la seguridad.

Redtelci puedes tenes mejorar la seguridad y el control del acceso de tu edificio

Tecnologia creada en colombia por Technological Solutions

2024-02-08

Cómo un prototipo que publiqué en internet termino siendo uno de los módulos para Flipper Zero mas vendido en Aliexpress

Para contar esta historia un poco de contexto: Flipper Zero es un dispositivo que desde su lanzamiento ha dado mucho que hablar por sus capacidades para hackear controles remotos infrarrojos, de radiofrecuencia, tarjetas de acceso NFC, RFID y hasta complejos ataques a redes WiFi

fuente: Que es "Flipper Zero" La Voz Argentina

Una de las aplicaciones por las que compre un Flipper fue para mejorar el desarrollo de un sistema de alarma que cree y quería probar si era vulnerable a los ataque éste, y una de las desventajas que encontré es su poco alcance en frecuencias Sub-GHz (inferiores a 1 GHz)

Para subsanar esta característica se agrego vía los puertos de expansión la capacidad de usar módulos de radio externos que permitieran mayor alcance y de uso muy común en el ambiente de Arduino tal como es el CC1101, entonces me puse de inmediato manos a la obra ya que contaba con el radio antes mencionado y construí mi modulo con los componentes que tenia a la mano y una placa de circuito universal.

Para contar con un modulo de expansión que pudiera adaptarse a varios tipos de radios y dado que a finales del 2022 no habían muchas opciones me di a la tarea de diseñar un modulo para que pudiera ser fabricado por alguno de los proveedores de PCB's como JLCPCB o PCBWay y fue así como quedo:

Este es el en lace a EasyEDA donde lo compartí: https://oshwlab.com/ianturo/flipperzero-nrf24-module

Y envié a fabricar un pequeño lote de 15 placas PCB que me costaron $6 dólares, a la que le soldé yo mismo los componentes y este fue el resultado final:

Hace poco hice una búsqueda en Aliexpres para módulos para Flipper Zero y oh... sorpresa... ya habían tomado el diseño (Open Source Hardware) para producir módulos para la venta en esta plataforma.

En fin resulto que un diseño que hice logro la fama internacional y ni me había enterado 🥴🤣

2023-04-16

Alarmas Para Edificios Que No Tienen Portero Desarrolladas Completamente En Colombia

Emprendimiento que creo la única alarma para edificios que no tienen portero

En Medellín, Colombia, una empresa está haciendo historia, No conformes con las opciones del mercado que según ellos esta diseñado mas para empresas o edificios con vigilancia que estén pendientes de anomalías, crearon un producto único que no solo corrige los problemas mas comunes de los edificios que no tienen vigilante permanente, tales como dejar la puerta abierta, desconocer el inventario de personas que tienen copia de la entrada o entradas no autorizadas con la intención de robar

2021-03-16

WebCam HD a buen precio

Con la pandemia llego la escasez de algunos componentes y accesorios esenciales para el teletrabajo, un ejemplo de ello fue el aumento tan vertiginoso de precio que tuvieron las cámaras USB o Webcams.

Una de las mas vendida la Logitech C920, paso a costar de unos US $90 a mas de US $150 si por suerte se conseguía algún lugar donde tuvieran stock.

Por suerte luego de buscar alternativas y que los reviews no me recomendaran comprar prácticamente ninguna de las opciones con marcas poco conocidas di con esta cámara de la marca Amcrest que ya había usado en el ámbito de la video-vigilancia, la AWC195-B una cámara Full HD de tan solo US $40 y puedo decir luego de unos meses de estar usándola que aun cuando no es perfecta es una muy buena alternativa.

2020-07-16

Windows 10 en una Raspberry Pi4 (Nuevos avances)

Ver tweet: https://twitter.com/NovaspiritTech/status/1283462732650618881/photo/1

2020-01-31

Enseñar programacion y algoritmos a niños

Enlace: Coding is Fun!